如何在本地搭建LLM并使用

写在前面

本篇来学习如何在Windows上安装属于开发者自己的大模型,主要以Ollama为例进行介绍。Ollama 是一款优秀的开源工具,让开发者可以在本地轻松运行和管理各种大型语言模型(LLMs)。

Ollama介绍

Ollama 是一个简化大型语言模型(LLM)部署和使用的工具。它具有以下特点:

- 本地运行: 模型完全在您的本地计算机上运行,无需联网,保护您的隐私和数据安全。

- 简单易用: 通过简单的命令行指令,即可下载、运行和管理各种 LLM。

- 模型丰富: 支持 Llama 2、Deepseek、Mistral、Gemma 等多种流行的开源模型。

- 跨平台: 支持 macOS、Windows 和 Linux 系统。

- 开放API:支持与OpenAI兼容的接口,可以和其他工具集成。

安装Ollama

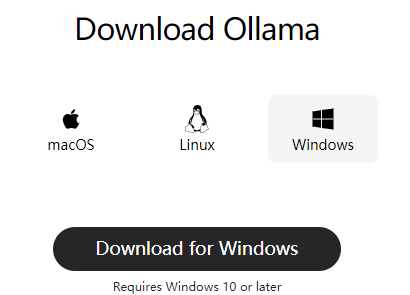

Windows平台安装

点击 Ollama官网,选择合适的版本:

之后笔者将其下载到F盘,但是笔者希望将Ollama安装到E盘的指定目录下,此时可以是以如下方式进行安装目录自定义:

执行该命令,之后就会将Ollama安装到自定义目录下。

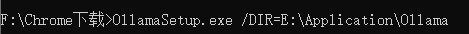

MacOS平台安装

点击 Ollama官网,选择合适的版本:

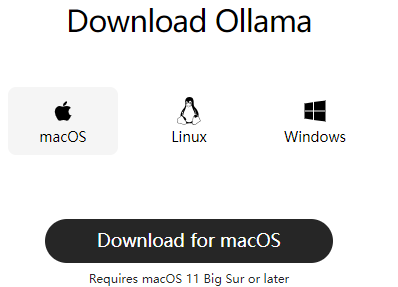

当然也可以到它们对应的github网站上获取:

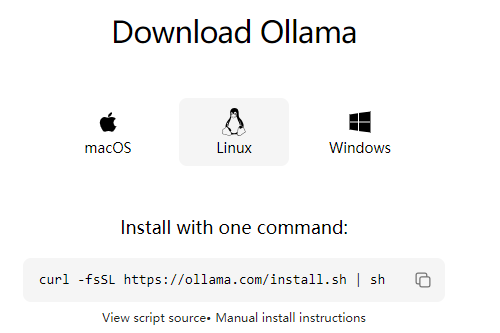

Linux平台安装

点击 Ollama官网,选择合适的版本:

可以看到这里没有提供直接的下载地址,而是使用命令:

1 | curl -fsSL https://ollama.com/install.sh | sh |

实际上就是下载并执行,不过由于网络波动,笔者还是建议先下载该脚本:

1 | wget https://ollama.com/install.sh |

之后修改Ollama的安装目录,安装成功后查看一下版本:

1 | D:\Application\ollama>ollama -v |

安装对应模型

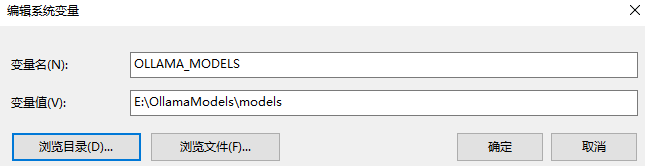

自定义模型安装路径

首先,停止运行Ollama,接着打开系统环境变量,在里面新增一个名为OLLAMA_MODELS的变量名,值为笔者打算存放模型的路径E:\OllamaModels\models,完整参数如下:

之后需要重新启动Ollama,这样才能保证自定义路径已经生效。

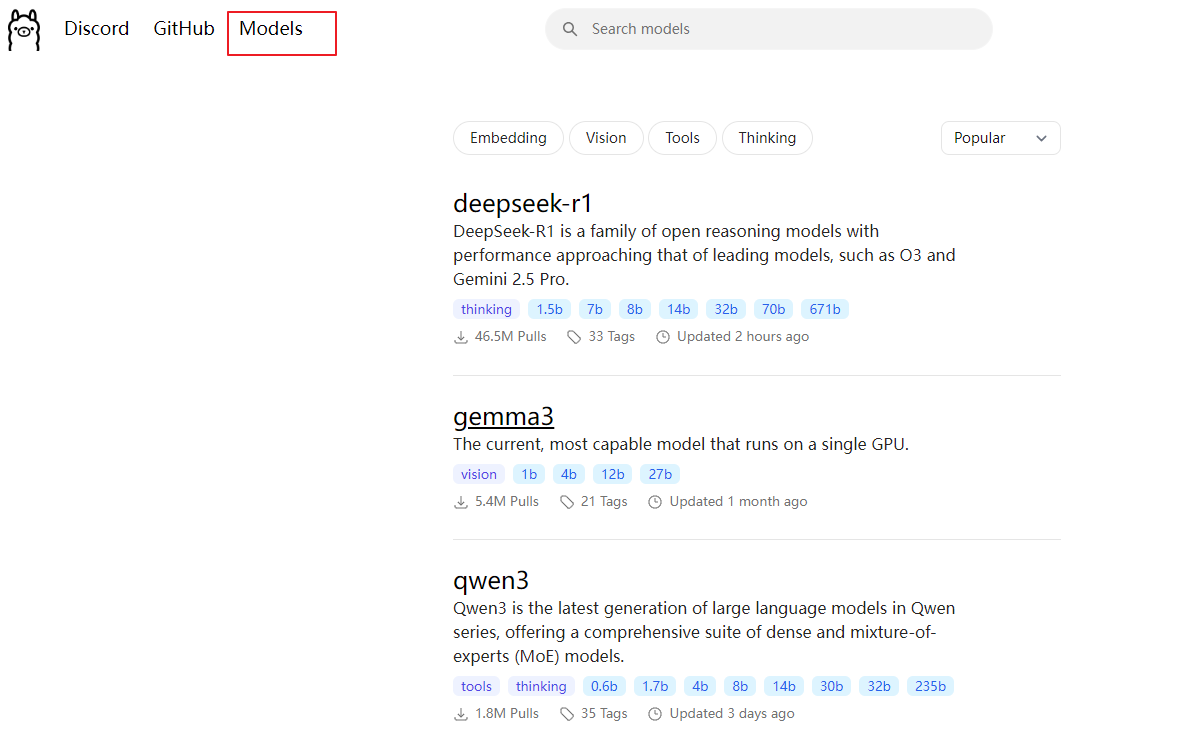

安装对应模型

点击Ollama官网中的Models模块,可以看到这里面列举了很多常用的模型:

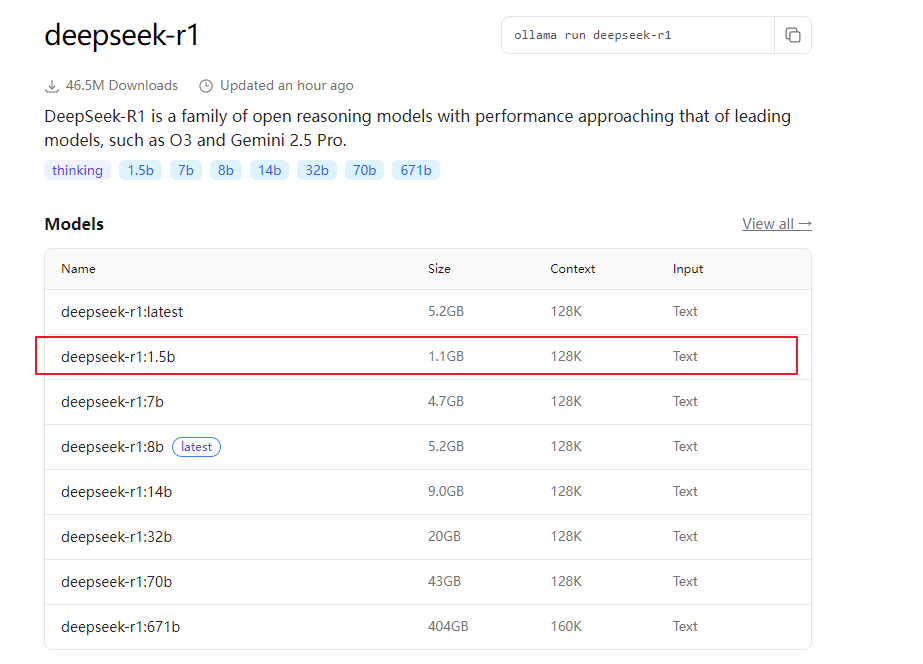

笔者这里选择deepseek-r1模型,同时选择了deepseek-r1:1.5b这一分支:

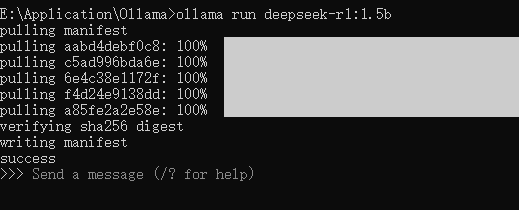

之后在控制台执行如下命令来运行对应模型:

1 | ollama run deepseek-r1:1.5b |

安装成功后,出现Send a message则表明已经安装成功:

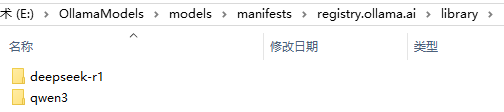

此时可以进入到之前自定义的模型存储路径:

也可以使用如下命令:

1 | E:\Application\Ollama>ollama list |

可以看到这里展示了笔者已经安装成功的2个模型。

可视化调用

尽管模型启动后,可以使用终端进行交互,但是界面不美观,而且不易于管理,因此笔者建议使用可视化工具进行调用,这里选择CheeryStudio。

为什么选择CheeryStudio

之所以选择使用CheeryStudio中使用Ollama,是因为它具有如下四个特点:

- 无需云服务: 不再受限于云端 API 的配额和费用,尽情体验本地 LLM 的强大功能。

- 数据隐私: 您的所有对话数据都保留在本地,无需担心隐私泄露。

- 离线可用: 即使在没有网络连接的情况下,也能继续与 LLM 进行交互。

- 定制化: 可以根据您的需求,选择和配置最适合您的 LLM

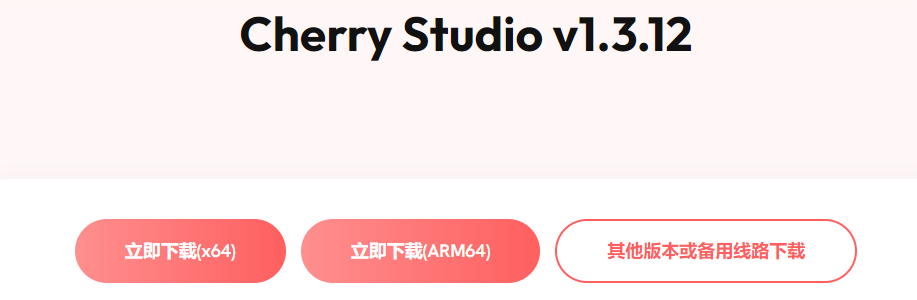

CheeryStudio的安装

点击 cherry官网,选择对应的版本进行下载:

请注意,在使用CheeryStudio与Ollama模型交互期间,需要保证Ollama处于运行状态。

配置Ollama模型

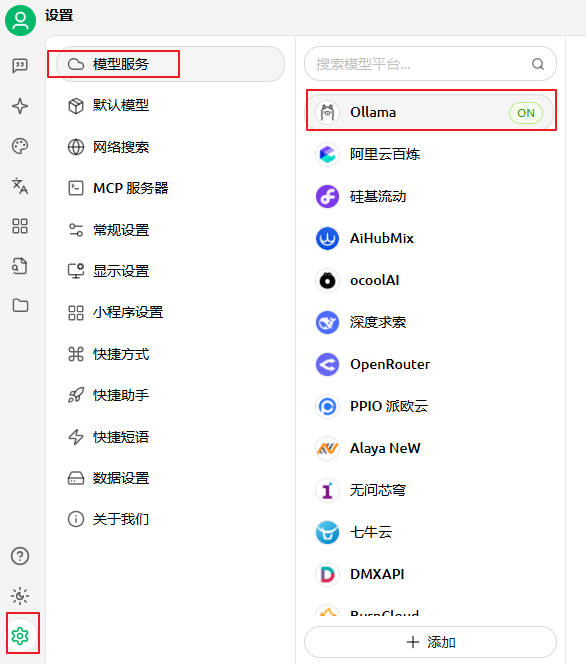

第一步,运行Ollama模型,然后打开CheeryStudio。

第二步,打开CheeryStudio中的设置,在设置页面选择模型服务,然后点击列表中的Ollama:

第三步,配置Ollama服务商。在服务商列表中找到刚刚添加的 Ollama,并进行详细配置:

- 启用状态:

- 确保 Ollama 服务商最右侧的开关已打开,表示已启用。

- API 密钥:

- Ollama 默认不需要 API 密钥。您可以将此字段留空,或者填写任意内容。

- API 地址:

填写 Ollama 提供的本地 API 地址。通常情况下,地址为:

1 | http://localhost:11434/ |

如果修改了端口,请自行更改。

- 模型管理:

- 点击“+ 添加”按钮,手动添加您在 Ollama 中已经下载的模型名称。

- 比如您已经通过

<font style="color:rgb(31, 28, 28);">ollama run llama3.2</font>下载了<font style="color:rgb(31, 28, 28);">llama3.2</font>模型, 那么此处可以填入<font style="color:rgb(31, 28, 28);">llama3.2</font> - 点击“管理”按钮,可以对已添加的模型进行编辑或删除。

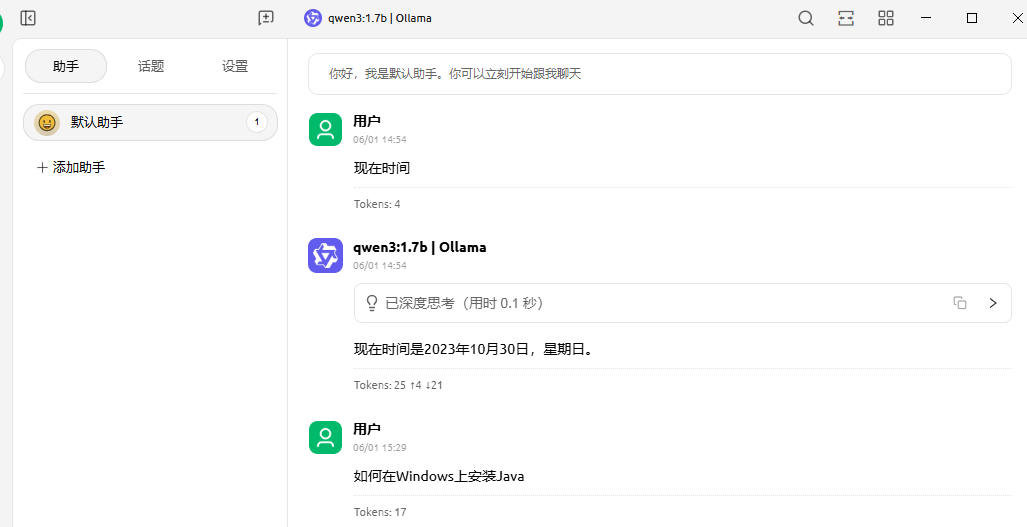

第四步,使用大模型。上述配置完成后,回到CherryStudio的聊天界面中,选择Ollama服务商和您已下载的模型,开始与本地 LLM 进行对话:

这样我们就实现了在本地部署LLM大模型,同时通过可视化界面与大模型进行交互。